目次

- 2021/05/23 NBS PresentationでCedrus Response Padを使えるようにする設定の方法

- 2019/11/20 Pythonで音声の開始時に音を追加する方法

- 2019/07/07 Arduino Unoで音声のオンセットを検出してトリガ出してみた

- 2018/01/07 100均LEDでレスポンスボックス自作してみた

- 2017/12/30 学振PDでアメリカの大学に行ってみた

NBS PresentationでCedrus Response Padを使えるようにする設定の方法

Windows 10にインストールしたNBS Presentationで、Cedrus Response Padを登録しようとしたときにエラーが出たのでその解決方法の備忘録です。

使用したもの

OS: Windows 10 (Pro Workstation用)

パソコン:Dell Precision 3640 Tower

レスポンスパッド:Cedrus RB-740

ソフト:NBS Presentation ver 22.1

パソコン:Dell Precision 3640 Tower

レスポンスパッド:Cedrus RB-740

ソフト:NBS Presentation ver 22.1

前提

レスポンスパッドをUSBケーブルで接続したとき、レスポンスパッドが認識されない場合、

USB Driver for Windows

をダウンロード・インストールする必要があります(もしリンクが切れていたらCedrusと検索し、Support > RB-x40 > INSTALLING AN RB SERIES PADの中から選んでください)。

認識しているかどうかを知りたいときは、デバイスマネージャー(Windowsマークを右クリックで表示できます)を開き、"NBS"が表示されているかどうかを見ます。表示があれば、認識されています。

エラーの内容

NBS PresentationでCedrus Response Padを使用したい場合、

Presentation Extension for Cedrus Response Devicesをインストールする必要がありますが、

Cedrusのサポートページの指示通りに実行すると、"Register Extension"ボタンをクリックした時点で以下のようなエラーが出てしまうことがあるようです。

There was an error registering thi sfile with Windows:

The file C:\Program Files (x86)\Cedrus XID Response Extension for Presentation\CedrusXidDriver.dll could not be loaded.

Windows returned the following error:

The specified module could not be found.

Please contact the extension provider for help

The file C:\Program Files (x86)\Cedrus XID Response Extension for Presentation\CedrusXidDriver.dll could not be loaded.

Windows returned the following error:

The specified module could not be found.

Please contact the extension provider for help

"Don't register server with Windows"を選ぶと、"Extension Cedrus XID successfully registered"と表示されるのですが、"Re-enumurate devices"をしたときにエラーが出て進めません。

解決方法

Microsoft Visual C++ 2005 Service Pack 1 再頒布可能パッケージをインストールするとこの問題が解消することがあるようです(何故かはわかりません)。

それよりも新しいバージョンも試しましたが、私のパソコンではうまくいきませんでした。

Presentationのforumsには同様の問題が2件報告されていて、

1件目は"MS Visual C++ redistributable package"をインストールしたらうまく行ったようです。バージョンはわかりません。

2件目は古いドライバを消して最新版をインストールしたらうまく行ったようです。

新しいパソコンだとそもそも古いドライバはないのでこっちは関係なさそうです。

【追記1】 別のパソコンで試したときはVisual Studio 2012(x86, x64)をインストールしたらうまくいきました。[link]

【追記2】Dependency Walker [link]をインストール → CedrusXID.DLLを読み込む → エラーが出ているDLL(例えばMSVCP100.DLLとMSVCR100.DLL)を見つける → 生成AIに投げるのが早いみたいです。API-MS-WIN-CORE-*.DLLのエラーは関係ないみたいです。

Pythonで音声の開始時に音を追加する方法

前回、Arduino Unoを使って、脳波実験のときの音声のディレイを検出する方法を紹介しました。

音声のディレイを検出するためには、音声の片方(RかL)にクリック音などを入れてArduino Unoに入力するほうが良いです(言語音の場合、母音など開始が検出しにくい場合があるため)。

音声のディレイを検出するためには、音声の片方(RかL)にクリック音などを入れてArduino Unoに入力するほうが良いです(言語音の場合、母音など開始が検出しにくい場合があるため)。

スクリプトは以下の通りです。input_folderは入力になるフォルダの名前、Sound_NoClick/*.wavは、そのフォルダ内で読み込みたい拡張子、

output_folderは、出力先のフォルダ、clickは追加したい音(Arduinoに検出させる音)です。

これらを自分のパソコンのフォルダの場所に合わせて変更してください。

Arduino Unoに聞かせる音は、Praatで簡単に作ることができます。

Pythonのインストール方法がよくわからないひとは、アナコンダをインストールすると良いと思います。

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

## Libraries ##

import os

import glob

from pathlib import Path

from pydub import AudioSegment

## Folders & Files ##

input_folder = Path("Sound_NoClick/")

input_file_name = [os.path.basename(p) for p in glob.glob('Sound_NoClick/*.wav', recursive=True) if os.path.isfile(p)]

# 特定の拡張子を持つファイルだけファイル名取得

output_folder = Path("Sound_Click/")

click = "1000HzSound.wav"

number_files = len(input_file_name)

## Pan and Add Click ##

sound2 = AudioSegment.from_file(click)

sound2 = sound2.pan(-1.0)

for i in range(0,number_files):

#file_number=str(i)

input_file = input_file_name[i]

output_file = input_file_name[i]

sound1 = AudioSegment.from_file(input_folder/input_file)

sound1 = sound1.pan(+1.0)

combined = sound1.overlay(sound2)

combined.export(output_folder/output_file, format='wav')

Arduino Unoで音声のオンセットを検出してトリガ出してみた

Arduino Unoを使って音声のオンセット(開始時点)を検出して脳波計にトリガを入れる方法を紹介します。

この情報がたくさんのひとの役に立つことはないと思いますが、そういう情報こそなかなかネットで見つけにくかったりすると思うので...

この情報がたくさんのひとの役に立つことはないと思いますが、そういう情報こそなかなかネットで見つけにくかったりすると思うので...

なんで音声のオンセットを検出したいのか?

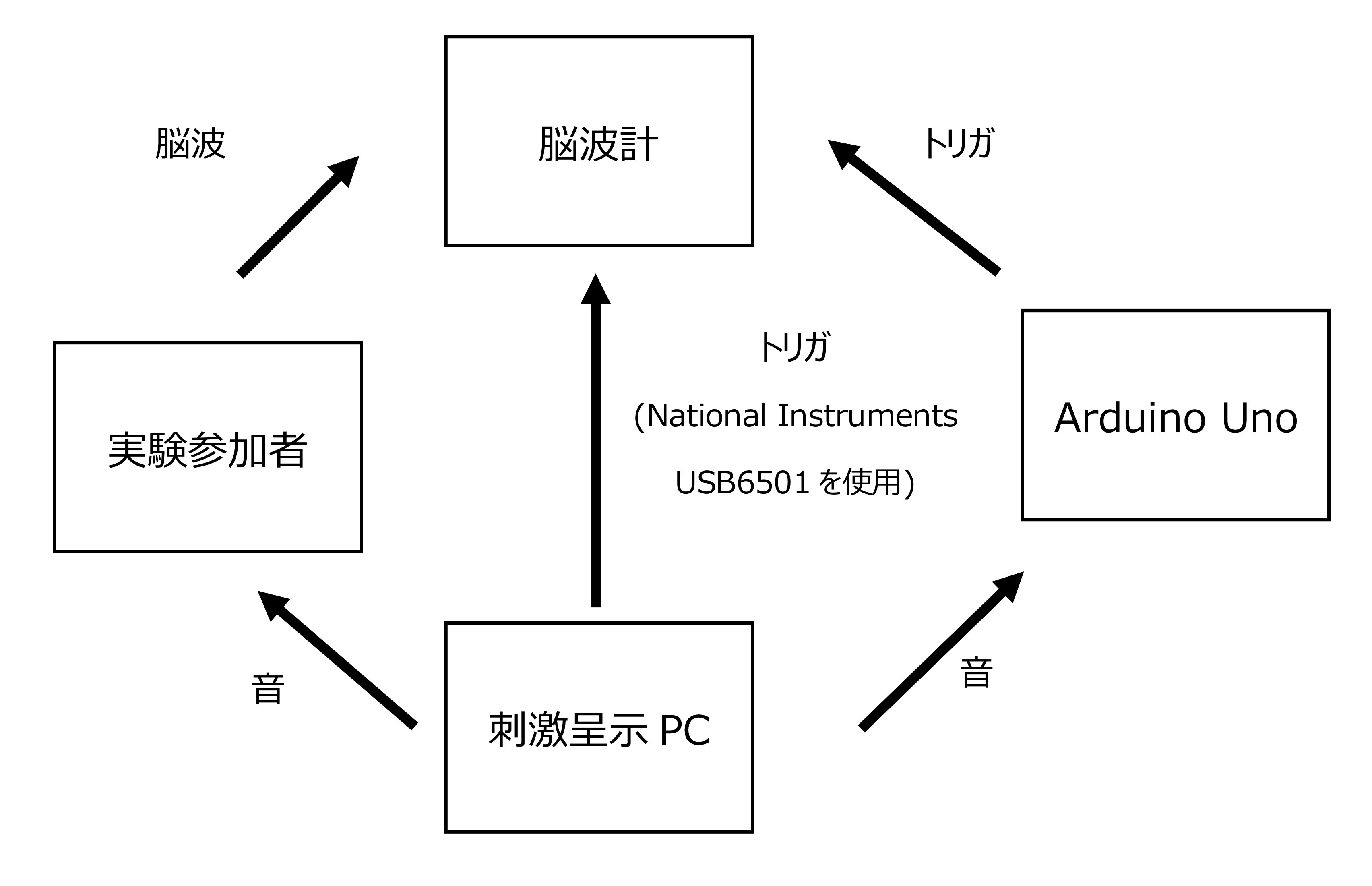

普段、脳波実験で音(文・単語など)を呈示するときNBS Presentationを使っているのですが、

Presenationが音を再生するタイミングが、

トリガ(National Instruments USB6501経由)を出力するタイミングから少し遅れてしまいます。

たぶん他のソフトウェアでもある程度同じようなことが起きると思います。

九大の設備だと30数ミリ秒くらい。脳波実験は、処理のタイミングに関心があることもあるのでこのズレは結構でかいです。

なので、音が実際に再生された音を拾ってそのタイミングに(ダミーの)トリガを出しておき、

解析時にPresentation側から出ているトリガをそのタイミングに移動させてしまおうということです

(トリガのタイミングを変えるのはEEGLABで簡単にできます)。

Arudinoを使うのは単に安いということと、使わなくなったときに別の用途で使える汎用性があるからです。

九大の機器の接続は以下のような感じです

用意するもの:

- Arduino Uno(アマゾンで買えます。たぶん生協とかでも)

- マイク・音センサー(矢野が買ったのはこれ)

- パソコン(MacでもWindowsでもOK)

- はんだ

- 半田ごて

- ケーブル(こんなもの)

さっそく作業に取り掛かります。

パソコンにArduinoのソフトをインストールします

下のDownload the Arduino IDEのところ。使用しているパソコンのOSにあったものをダウンロードします。

寄付したいひとは寄付できますが、Just Downloadでも問題ないです。

USBケーブル(Arduinoキットを買うと付いてくる)でArduinoとパソコンをつなぎます。

ファイルをダウンロードし、Arduino Appで開きます(ファイル > 開く > ファイルを選択)。

「マイコンボードに書き込む(→)」をクリックし、Arduinoにスクリプトを書き込みます。

この時点でうまくいかない場合、Arduinoが認識されていない可能性があるので、

ツール > シリアルポートでArduinoがささっているUSBポートが正しく選択されているか確認してください。

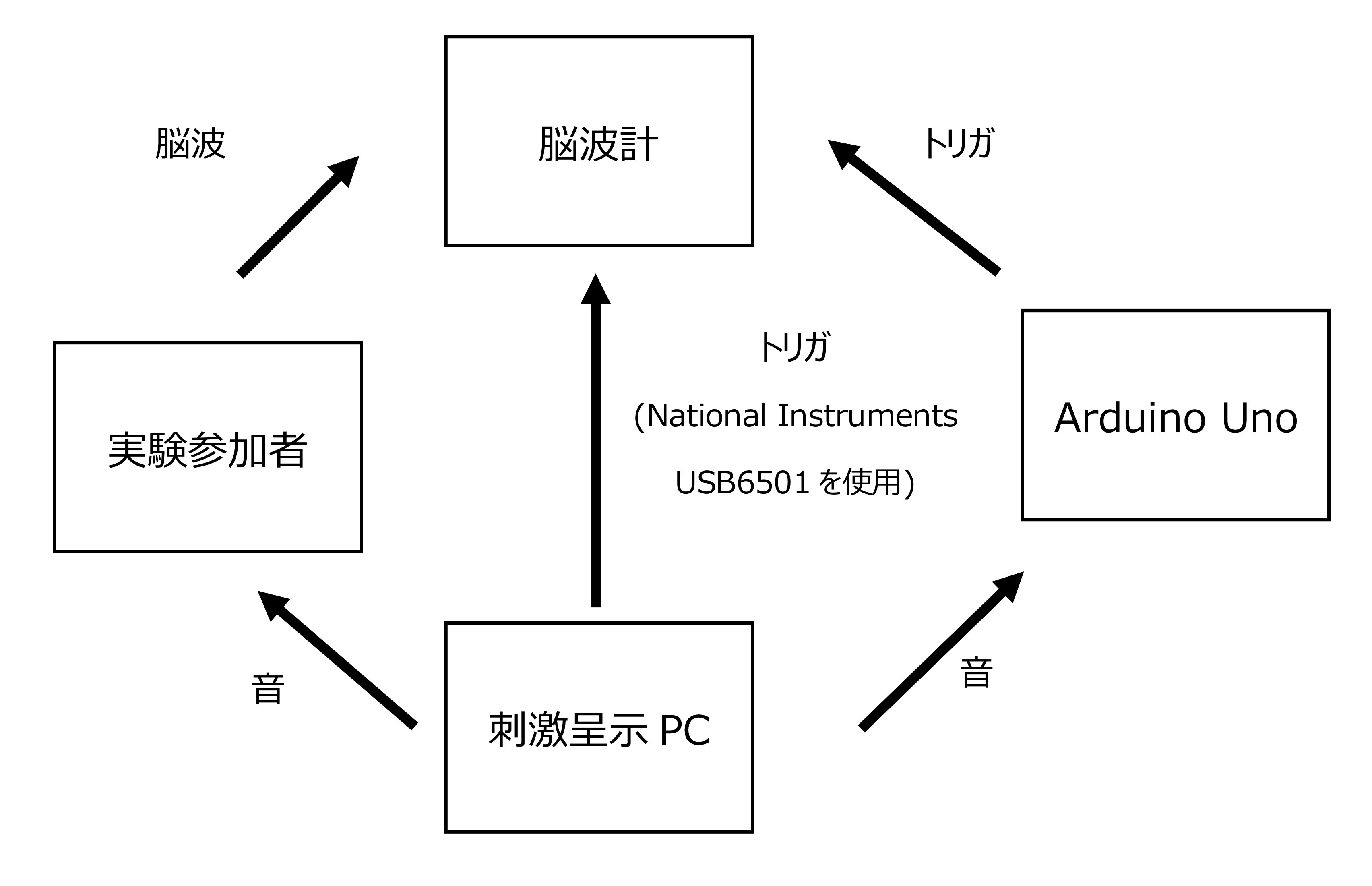

Arduinoとマイクを接続します(載せるだけ)

ArduinoのA4とGNDにケーブル(オス側)を指します。

ケーブルのもう一方は、脳波計のトリガ入力のピンにはんだ付けします。

九大の脳波計だとD-sub25ピンの内、8ピンまで使っているので(National Instrumentsから来るトリガ)、9ピン目を使用しました。

*何番まで使えるかは脳波計に依存します。所有してる脳波計のピン配置を確認してください(取扱説明書にも書いてありますが、わからなければメーカーか販売代理業者などに問い合わせすると教えてくれます)

音声を流してみて、トリガが出ているか確認すれば作業は終了です。

Arduinoの音センサーに直接イヤフォンなどをテープなどで止めると検出しやすいです。

EEGLABで脳波解析をしている場合、データを読み込んだあとにMATLABのCommand WindowにEEG.event(1).latencyと入力することで、

トリガの時間にアクセスできるので、Arduinoが出したトリガのタイミングに、その他(=NIから出ているトリガなど)のタイミングをあわせるようなスクリプトを書くと良いです。

余談:困った話

言語音を使う場合、音声の開始が弱い(母音とか)ことがあって、Arduinoが正確にオンセットを検出できないという懸念があったので、

再生する音声の左側にクリック音(オンセットがはっきりしているもの)、右側に実際に参加者に聞いてもらう音声を入れて、

Arduinoには左側から出た音声を聞かせ、参加者には右側から出た音声を聞いてもらうようにしました

(ステレオ->モノラルアダプタ(cf. JVC)で音声を左右を分け、右側にイヤフォンをさせば参加者は両耳で同じ音声が聞けます)。

しかし、実験用パソコン(HP EliteDesk 800 G4 TW/CT)でそれを再生してみると、左側でも音声が聞こえ、右側でもクリック音が聞こえるという問題が起こりました

(一応、HPサポートセンターに聞いてみましたが、"想定した用途を超えるもの"でそれがソフトウェアの問題なのかハードウェアの問題なのかわからないとのことでした)。

どうやら左と右の音声が混線?しているようで、色々とネットで検索してみるとハードウェアの問題ではなくHPもしくはWindows 10で動いているソフトの問題みたいです(「立体音響」など色々設定をいじってもだめだった..)

しかし、この問題はEqualizer APOを使えば解決するみたいです。ソフトを開いて、Selected channelsのところでALLを選択します。

これで、左右別々に音声が再生されるようになりました :)

100均LEDでレスポンスボックス自作してみた

脳波・行動実験などで使用できるレスポンスボックスの自作方法を紹介します。

なぜ自作するのか?

脳波実験などでは、実験者が操作する刺激呈示用パソコンからVGAケーブル等で別室にあるモニターにつなぎその映像を実験参加者に呈示することが多いと思います。

このようなケースでは、実験参加者は、実験刺激を呈示するパソコンのキーボードから離れた位置におり、キーボードを押せないので、Cedrus製Response Boxなどを購入してレスポンスを記録することになります。

しかし、Cedrus製のレスポンスは高く(RB0740は2017年7月時点で8万円程度 [ユニポス])、若手研究者(特に研究費がない院生)には手が出しにくいです。また、高齢者や子どもなどを対象とする実験では、

Cedrus製のレスポンスボックスだとボタンがやや小さく押しにくかったり、タスクに関係ないボタンがあるために参加者が混乱したりするという意見がありました。そこで、実験参加者フレンドリーなレスポンスボックスを安く作る方法を考えました。

以下で紹介する方法は、ゲームコントローラーに接続さえできればボタンの大きさ・個数は自由に決められます。

用意するもの:

- USBコネクタでパソコンに接続できるゲームコントローラー(エレコムゲームパッドだと1000円前後、たまに700円くらいになる...)

- ダイソーLEDライトまたはボタンとして使用したいもの(参考:マルツオンライン)

- はんだ

- 半田ごて

- プラスドライバー

- コード

- ハサミ

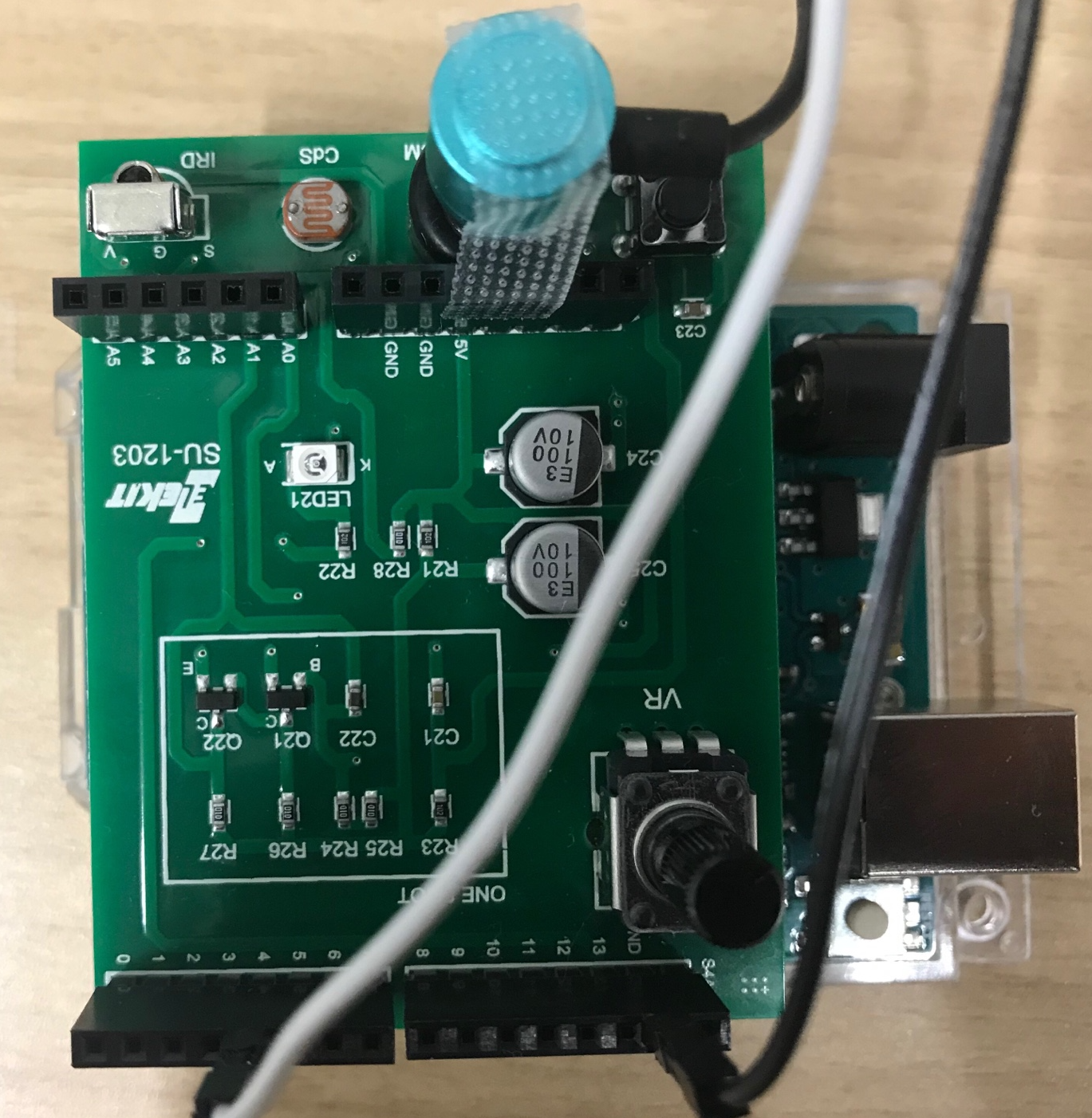

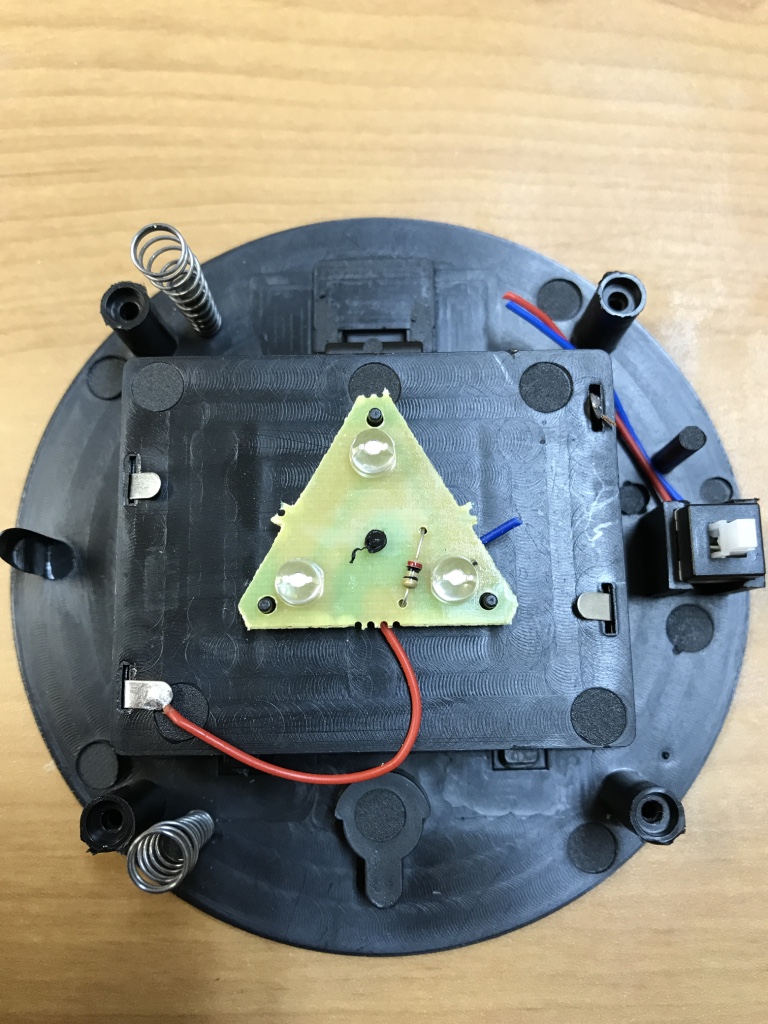

さっそく作業に取り掛かります。まず、ゲームコントローラーを開いて、以下のような状態にします。

このゲームコントローラーでは数字がついているところが使える場所です。右4つに1、2、3、4、真ん中に9、10と小さく書いてあります。それ以外の番号は上側についている4つのボタンです。今回は右4つと10番を使用しました。

コードを2本準備し、丸い部分の片側に一本ずつはんだ付けします。この時、はんだが、反対側までつかないように気をつけて下さい。

これでコントロラー側の準備は終わりです。

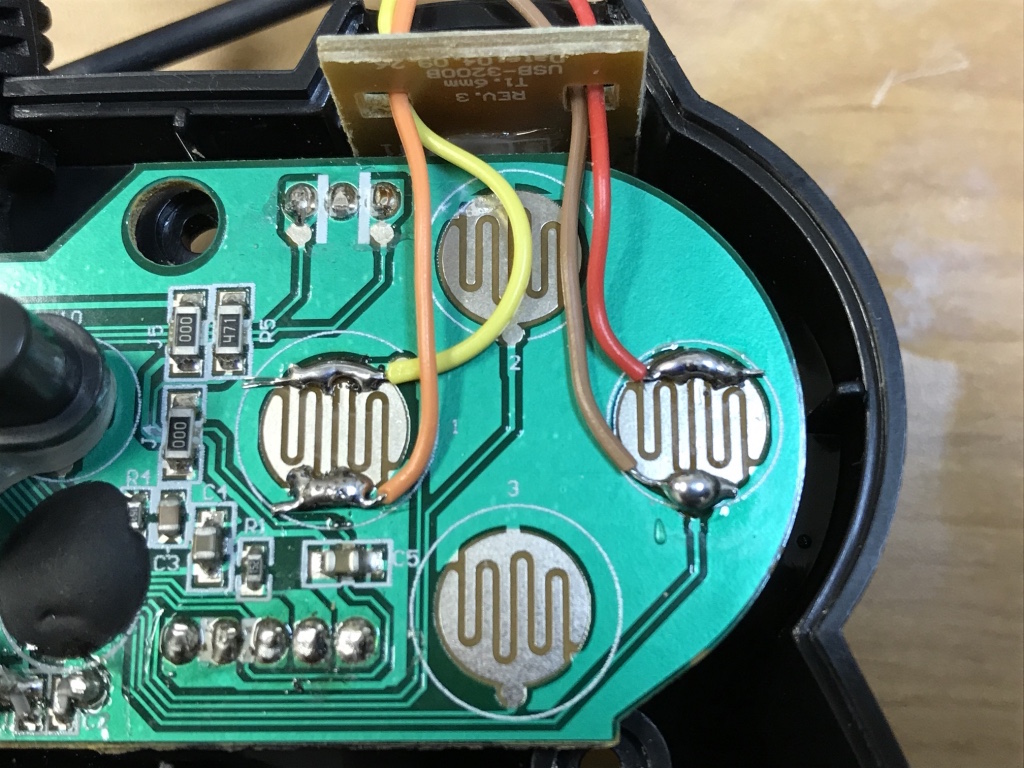

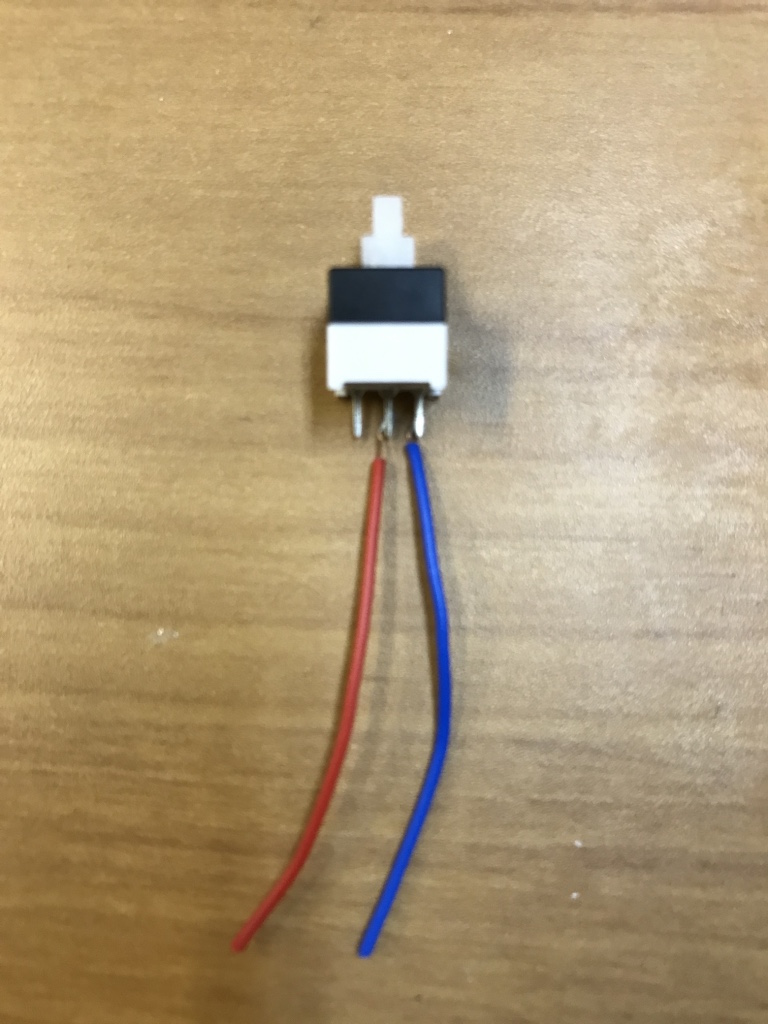

先ほどはんだ付けをしたコードの反対側をボタンにつけていきます。今回は、ボタンとしてダイソーで購入したLEDライトを使います(高齢者・子どもの実験用に使用するので大きめのものを使用)。LEDライトのカバーをプラスドライバーで外し、スイッチの部分についているコードを切ります。

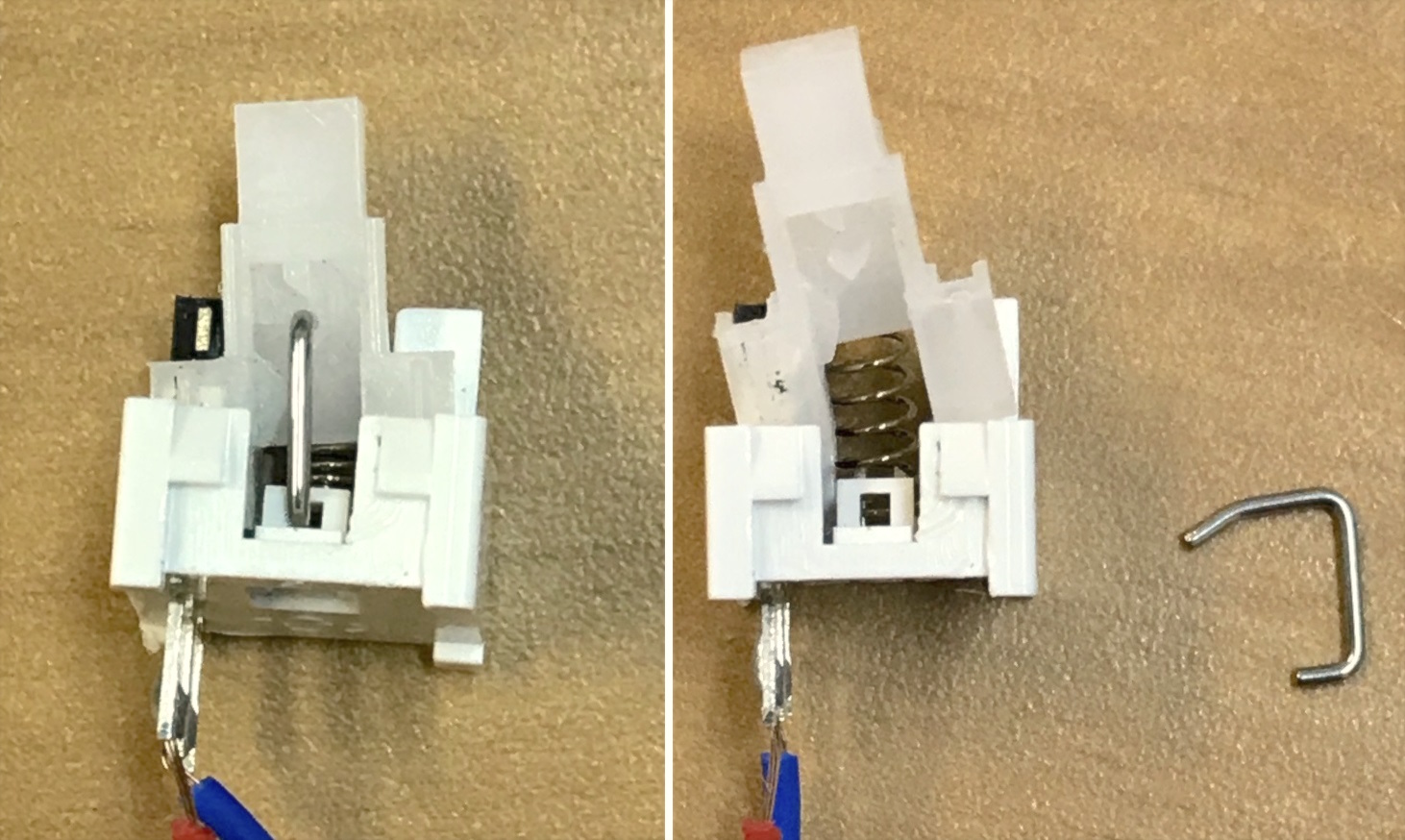

スイッチ部分を取り出します。このスイッチは、押すとオンの状態のままになってしまうので、ボタンとして使用するために留め金を外します。取り外すのは、バネの反対側にある「コ」のような形をしたものです。撮影のために完全に上のカバー部分を外していますが、カバーを外すとバネが取れやすくなるので、カバーを半開きの状態にしてマイナスドライバーでうまく取り出す良いです。

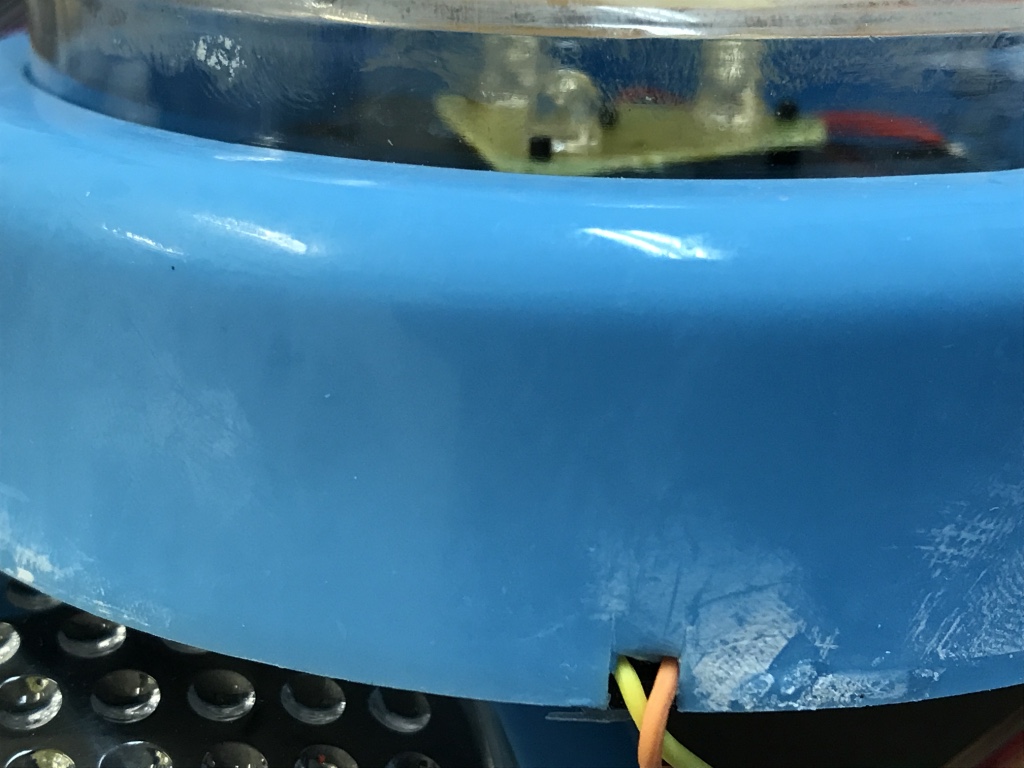

先ほど片側をコントロラーに付けたコードの反対側をはんだでスイッチに付け、スイッチをLEDライトに戻しカバーを付けます。カバーを付ける際に、コードがじゃまになるので、カバーの下の方に隙間を空けてそこから出すと良いです(これは好み)

これで完成です。

脳波実験などで使用しているPresentation(Neurobehavioral Systems)であれば、コントロラーのUSBをパソコンに接続しSettings > Response > Game Pad(たしか笑)> Buttonsで使用するボタンを選択しUse > Testで動作確認ができます。

動作確認のとき、ボタンのリリースではなく、ボタン押しが反応として記録されていることを確認しておいた方が良いです。

その他の方法だとJoyToKeyというソフトで、ゲームコントローラーのボタン押しをキーボードに置き換えることができます。

あんまりちゃんと確認してないですが(文処理の脳波実験は通常ミリ秒単位での反応時間の正確さは必要ないので)、Flanker TaskをPsychoPyで作成し自分でやってみた限りでは、キーボード vs. Cedrusのレスポンスボックス vs. 自作レスポンスボックス(JoyToKey使用)で、反応時間・反応の記録ミス率に差はありませんでした。

学振PDでアメリカの大学に行ってみた

受入研究機関・時期などによって異なる部分もありますので参考程度に.

学振研究員とは?:

大学院生やポスドクに研究奨励金と研究費を給付する制度です。博士後期課程の大学院生が応募するDC、ポスドクが応募するPDなどがあり、奨励金はそれぞれ月額20万円、月額36万2千円、科研費は150万円以下です。採用期間(2〜3年)の2/3は、海外の研究機関において研究を行うことができます(ただし正規の学生として在籍することはできません)

*「通算渡航期間の上限について」H30年4月1日付けで変更があったようです[link])。

私が採用されているのは、「国内学振PD」と呼ばれるものです(それとは別に「海外学振」というのもあります)。

制度の詳細:

アメリカに行くためにしたこと・必要なこと:

-

アドバイザー探し

まずは先生と直接連絡を取りました。1回目(2016年9月頃)にお願いした先生からは中々返事が返ってこず、やんわり断れました。その後、別の先生と連絡を取り(2017年2月)、1週間後くらいにfaculty meetingでOK出たよ!という連絡がありました。共通の知り合い(自分の指導教員/その他の先生/ポスドクなど)に問合せが行っていたようなので、メールに予め照会先を書いておいた方が良かったかもしれません。4月開始だとVISA申請が間に合わないと事務に言われ、9月から(最長で)1年間行くように変更しました(勿論、就職などで途中で帰ることもできます)

-

書類集め

VISAを取るためには大学または研究室の事務と連絡を取り、DS-2019を発行してもらう必要があります。そのために、書類・証明書を集めます。私が集めた書類は、以下の通りです:

-

学位取得証明書

学振PDでいくひとはJ1 VISAになるらしく、博士号の取得証明書(英語)(と成績証明書?)が必要みたいです。メリーランド大の規定には「J1 VISAを取るためには少なくとも学部卒以上」と書いてあったので、てっきり博士号の証明書だけを出せば良いと思っていたら、学部卒の証明書も必要でした(大学から郵送してもらうと1〜2週間かかる)

-

所得証明書

日本学術振興会に書類(採用中のひとは「採用証明書交付願」、採用内定のひとは特別研究員採用見込証明書交付願)を送り、発行してもらいます。問合せたところ(2017/03/10)、科研費の支給額は記載してもらえないそうです。ちなみにメリーランド大学でJ1 Scholarとして受け入れ可能な最低所得額は、以下の通りでした。所得の面でVISAが取りにくいという情報も聞いていましたが、特に問題はありませんでした(独身なので。配偶者と子どもがいると以下の額超えます)Required Minimum Funding AmountsAnnualMonthlyJ-1 Scholar Only$26,370$2,197.50Each Dependent$4,500$375

-

TOEFL iBT Score Report

(たぶん英語圏以外の大学で学位を取った場合):テスト受験後2週間くらいでダウンロードできるPDFでOKでした。大学によって最低点は異なるらしいですが、メリーランド大の場合80点以上で、これを下回ると受け付けてもらえません。TOEFL以外にもIELTSだったり、その他のテストでも良いケースがあるそうです。メリーランド大学の場合は、メールで書類を送るのではなく、専用のウェブページにアップロードする形式でした。あとは事務から送られてきた誓約書?(何日から何日まで滞在するとか)に自分のサインと国内の受入研究者のサインを書いて、スキャンして送りました。基本的に書類は、郵送するのではなくウェブにアップロードするか、メールで送ることになるので、スキャンできる複合機(研究室とかにあるでかいやつ)がすぐに使えると便利です。 渡航先の大学側には関係ないですが、日本学術振興会に、「特別研究員海外渡航届」の提出が必要です(受入研究者の欄は、国内の受入研究者なので注意)。この書類は、渡航期間が28日以上変更になった場合、再提出が必要になるそうなので、日程が確定してから提出したほうが良いかもしれません。

-

学位取得証明書

-

面接の予約

書類がすべてそろうと受け入れてもらえるかの審査が始まり、パスするとDS-2019が郵送されてくるので、次は面接に行きます。アメリカ大使館のサイトの指示に従って、DS-160申請書を作成し、手数料を支払い、面接の予約をします。過去の渡米歴を入力するのが大変なので予めチェックしておくと良いです。面接が終わると2週間程度でパスポートが送られてきます。提出したおいた学位証明書なども一緒に帰ってきました。特にDS-2019は渡航後も必要になることが多いのでなくさないようにー

-

ケータイ

SIMフリーのiPhoneをApple Storeで買い、SIMカードをアマゾンで買って使うことにしました。海外使い放題プランなどがあるキャリアもあるみたいですが、アメリカ国内で使っていても電話する時は国際電話になってしまというネット情報を見たので、SIMカードを買って使うほうを選びました。大学や家ではWi-Fiが使えるので月額2GB 30ドルくらいのプランで全然問題ないです。 * リンク先のSIMカードはアクティベートする際、郵便番号を入れるとエラーがでるみたいですが、住所を入力していれば郵便番号は入れなくても良いみたいです。

-

予防接種

各研究機関のサイトで必要な予防接種が公開されているみたいです。メリーランド大学は、↓ http://health.umd.edu/clinicalservices/allergimmuntravel/immunizations メリーランド大学の場合、J1 VISAのひとは義務的ではないみたいでしたが、一応、学生に要求されている予防接種を受けました。予防接種は、種類によって1週間〜1ヶ月あけないと次の予防接種ができないそうなので、早めに対応したほうが良さそうです(特にお子さんも一緒に行く場合)。メリーランド大学の学生の場合、T-dapという種類のものが必要でしたが、最初に行った病院の医師によるとT-dapは日本には置いていないことになっているらしく(?)、輸入ワクチンを使っている病院を探す必要がありました。あと、T-dapや髄膜炎菌の予防接種は、めっちゃ高いです(たしか1万5千円と2万5千円くらい)。

-

家探し

メリーランド大学側からOff-campus Housing Serviceのサイトがあるので、そちらで探すように指示がありました。VISA取得後出発まで時間がなかったので1週間のうちにいくつか空いていそうなところに連絡を取りました。最後に決める前に、家主がSkypeをしようと言ってきたので、ハウスメイトと一緒にSkypeをして、その時にハウスシェアのルール・治安・近くのお店などを聞きました。現地につくと手続きでバタバタするのでできるだけ日本にいる内に決めておくと良いと思います。

-

国外免許

日本の自動車免許を持っているひとは、免許センターに申請して国外免許を取得できます。必要なものは、パスポート・免許証・写真1枚(縦5cm x 横4 cm、サイズに注意)・印鑑です。有効期限は発行日から1年です。即日発行できるセンターと、後日発行になるセンターがあります(ネットで確認できる、福岡の場合:http://www.police.pref.fukuoka.jp/kotsu/unshi/031.html)。視力検査などはなく、書類の提出・料金の支払いを済ませたら、(混んでいなかったので)10分程度で発行してもらえました。

-

健康保険

大学側が提示する条件を満たす保険会社のプランを自分で探して購入し、その証明書を提出するケースと、大学側が提示してくるプランを購入するケースがあるので、まずは、その確認が必要です。メリーランド大学では、2017年8月から後者のほうに変更になり、大学のHealth Centerで手続きをしました。J1 Visaのひとは大学院生と同じプランで1年で20万円くらいでした(半年毎に購入する方法もあり、就職などで帰国が早まる可能性のあるひとはそっちのほうが良いかも)。自分で探す場合は、ネットで口コミ情報も参考にしたほうが良いみたいです。

-

Social Security Number

これも大学にもよるかもしれませんが、J1 Scholarとして行く場合は、Social Security Number (SSN)の取得が必要らしいです。近くのSocial Security Administrationに行って申請します。必要な書類などは以下のサイトにとてもわかりやすくまとめられていました。

おまけ

2年ルールと24-month bar

学振研究員がJ1 Visaで渡航する場合2年ルール(と24-month bar)が適用されるみたいです。これを回避する方法もネットで散見されますが、アメリカでそのまま就職を考えているひとなどは、渡航を決める前に制度を理解しておいたほうが良いかと思います。

学振DCの場合

私が知る限り、「学振DC」や「学位取得による学振PDへの資格変更(研究奨励金はDCと同じ)」だと、少なくともメリーランド大学では、要求される最低給与額を下回ります。この問題を解消する方法としては、「若手研究者海外挑戦プログラム」に応募する方法があるかと思います。また、聞いた話では、海外での滞在を出張扱いにして科研費から日当を出すことができ、給与+日当の合計額で最低給与額をクリアできる可能性もあるそうです。学振DCでも海外渡航しているひとはいますので、各大学の事務に早めに、受入れ条件を問合せておくことをオススメします。

渡航時期について

就活のことを考えると、学振PD 1年目に行くのが良いですが、4月から行くと、博士論文を書きながらVISAの手続きを進めなければならないことや、保険・予防接種・VISA申請・奨学金の返済などのお金をどうするかなど、結構大変だと思います。なので個人的には1年目の9月スタートがベストだと思います。Fall Semesterから行くと、新入生などもいるので、自己紹介などをする機会もありますし、日本で言う前期->後期の順で授業が聴講できるというメリットがあります。

また1年目に行けば、帰国してから、まだ就活期間の余裕があります。私は2年目9月に出発したのでアメリカ滞在中に就活をしていますが、応募書類の送付(FedEx)に毎回100ドル程度かかるので結構痛いです...着いてからは、様々な手続きでバタバタするので、授業開始の2週間程度前(8月末頃?)には着いておくことをおすすめします。